La gran mayoría de la gente se encuentra más que familiarizada con el primer tipo de macromoléculas que vamos a estudiar: los carbohidratos. Y ello se debe a que se trata de uno de los principales protagonistas en muchísimos tipos de dietas, tanto en las de bajo contenido en este macronutriente para aquellos que buscan pérdida de peso, como aquellos que necesitan un gran aporte energético en su vida diaria, como es el caso de los deportistas.

Los carbohidratos desempeñan muchas funciones en las plantas, animales y el ser humano, siendo parte esencial en nuestra alimentación, al proporcionar energía (4,3 Kcal/g) al organismo, principalmente a través de la glucosa.

Entre las fuentes naturales ricas en carbohidratos encontramos las verduras, frutas y cereales.

Su estructura molecular se representa mediante la fórmula (CH

2O)

n, donde n nos indica el número de átomos de carbono en la molécula. Por tanto, en los carbohidratos la proporción C, H, O siempre va a ser de 1:2:1.

Este tipo de macromoléculas se clasifica en tres tipos:

monosacáridos,

disacáridos y

polisacáridos.

Monosacáridos

Los monosacáridos son moléculas que pueden adoptar tanto forma de cadena lineal como de anillo, encontrándose estos últimos normalmente en soluciones acuosas.

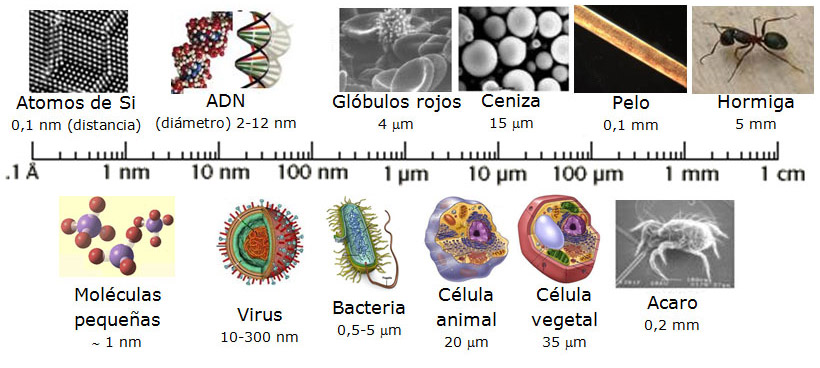

Se trata de azúcares simples (mono-: uno, sacar-: dulce), siendo la glucosa el más común de todos ellos. La gran mayoría de ellos se denominan con el sufijo “-osa” conteniendo un número de átomos de carbono que varía entre tres y siete. Así, hallamos por ejemplo, la triasa (3 carbonos), la pentosa (5 carbonos) o la hexosa (6 carbonos).

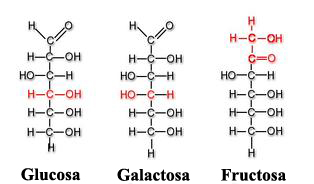

Si cuentan en su estructura con un grupo aldehído[1] el monosacárido se conocerá como aldosa, en cambio se denominará cetosa si el grupo funcional que posee es una cetona[1].

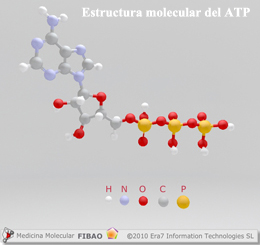

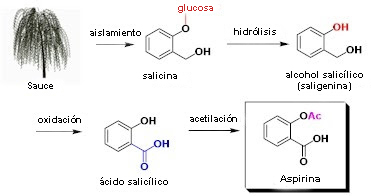

La glucosa (C6H12O6) es una de las fuentes energéticas primordiales del ser humano de la cual se va a liberar energía durante la respiración celular, empleándose dicha energía para la fabricación de ATP (trifosfato de adenosina)[2]. Las plantas van a sintetizar la glucosa utilizando CO2 y agua, almacenando sus excedentes en forma de almidón, que será catabolizado (descompuesto por las células) al ser consumido por los seres humanos y animales herbívoros.

Entre otros monosacáridos también destacan la galactosa (que forma parte de la lactosa o azúcar de la leche) y la fructosa (forma de azúcar presente en las frutas y la miel). Tanto la glucosa, la galactosa y la fructosa son hexosas y ejemplos de monosacáridos isoméricos al poseer la misma fórmula química (C6H12O6) pero diferenciarse estructural y químicamente debido a las distintas disposiciones de sus grupos funcionales en torno a los carbonos asimétricos[3].

La glucosa y la galactosa pertenecen al grupo que veíamos anteriormente denominado aldosas y la fructosa a las cetosas.

Disacáridos

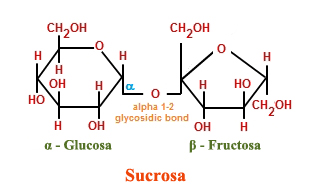

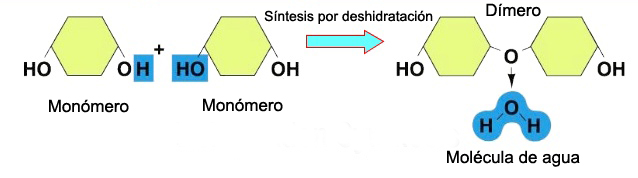

Los disacáridos (di-: dos) se van a constituir cuando dos monosacáridos se someten a una reacción de síntesis por deshidratación. Durante este proceso el hidrógeno de uno de los monosacáridos se combina con el grupo hidroxilo de otro monosacárido, formando un enlace covalente entre ambos y liberando una molécula de agua. Este enlace covalente se denomina enlace glucosídico, los cuales se dividen en dos tipos: α y β, dependiendo de si el grupo hidroxilo (OH) se posiciona por encima o por debajo del carbono quiral.

Entre los disacáridos más habituales se hallan la lactosa, la cual es el resultado de la unión de los monómeros galactosa y glucosa, encontrándose presente de forma natural en la leche. La maltosa, o azúcar de malta, formada a partir de la reacción de deshidratación de dos moléculas de glucosa es otro ejemplo de disacáridos. Pero sin duda, el más común de todos ellos es la sacarosa, o azúcar de mesa, compuesta de monómeros de fructosa y glucosa.

Polisacáridos

Los polisacáridos (poli-: muchos) son largas cadenas de monosacáridos unidos por enlaces glucosídicos. Estas cadenas pueden ser ramificadas o sin ramificar conteniendo diferentes tipos de monosacáridos. Entre los principales polisacáridos destacan el almidón, el glucógeno, la celulosa y la quitina.

Almidón

Las plantas son capaces de sintetizar la glucosa, como comenté anteriormente, a partir de agua y CO2. Cuando su producción sobrepasa las necesidades energéticas de la planta, los excedentes se van a almacenar en forma de almidón en distintas partes de la misma, incluyendo la raíz y las semillas, a las que les proporcionará alimento durante la germinación de las mismas.

El almidón al ser consumido en la dieta por animales y seres humanos es descompuesto previamente por enzimas, como las amilasas salivares, en moléculas de menor tamaño como la glucosa antes de ser absorbida por las células y satisfacer así las necesidades energéticas de éstas.

Glucógeno

El glucógeno, compuesto de monómeros de glucosa, es la forma de almacenamiento de ésta última en los humanos y otros vertebrados. Se le considera el equivalente animal al almidón de las plantas, acumulándose en las células musculares y el hígado.

Cuando los niveles de glucosa en sangre disminuyen se recurre a estos depósitos descomponiendo el glucógeno para liberar la glucosa que lo constituye en un proceso denominado glucogenólisis.

Celulosa

La celulosa, constituida también por monómeros de glucosa, es el biopolímero más abundante. Se trata del principal componente de las paredes celulares de las plantas confiriéndolas soporte estructural.

En este tipo de moléculas sus monómeros constituyentes se hallan fuertemente empaquetados dando a la celulosa su típica estructura fibrosa confiriendo a las plantas dos características muy importantes para ellas: rigidez y elevada resistencia a la tracción.

A diferencia del ser humano, los animales herbívoros cuentan en su sistema digestivo con bacterias y protistas[4] que segregan la enzima celulasa, ayundádoles a digerir la celulosa presente en los pastos que consumen, descomponerla en monómeros de glucosa y como consecuencia poder aprovecharla como fuente de energía.

Quitina

El cuarto polisacárido a destacar es la quitina. Es un polisacárido con alto contenido en nitrógeno constituida por unidades repetidas de N-acetil-β-glucosamina, un tipo de azúcar modificada.

La quitina es un componente principal de las paredes celulares de los hongos y del exoesqueleto (esqueleto externo) de los artrópodos que protege sus órganos internos.

BENEFICIOS DE LOS CARBOHIDRATOS

Los carbohidratos se componen de elementos tanto solubles como insolubles. Entre los segundos encontramos la fibra, que es principalmente celulosa. La celulosa ayuda a regular el tránsito intestinal y regula la tasa de consumo de glucosa en sangre. Además favorece la eliminación del exceso de colesterol en sangre uniéndose a él en el intestino delgado, y evitando, de esta manera, que forme parte del torrente sanguíneo, excretándose por medio de las heces. Asimismo, las dietas ricas en fibra desempeñan una misión protectora contra la aparición del cáncer de colon.

La glucosa proporcionada por los carbohidratos que consumimos, una vez ha sido descompuesta durante la respiración celular, va a producir moléculas de ATP, que se caracteriza por su rápida aportación de energía al organismo. Como consecuencia, sin el consumo de carbohidratos la disponibilidad de energía instantánea se vería profundamente reducida.

Debido a todas estas razones, eliminar la ingestión de carbohidratos, como algunas dietas hipocalóricas propugnan, con el fin de producir una rápida pérdida de peso se convertiría en un gran error. Para tal objetivo, sería una solución mucho más sensata y saludable el consumo de los carbohidratos adecuados a través de verduras, frutas y cereales en combinación con un contenido equilibrado de proteínas, vitaminas y grasas y la realización de ejercicio adaptado a nuestro estado físico, edad y sexo.

Fuentes: OpenStax College, Biology. OpenStax College. 30 May 2013.

http://medmol.es/glosario/121012glosariomedmol_atp/

https://kel-tay-lii.wikispaces.com/A.+Intro+to+Phys

http://chemistry.tutorvista.com/organic-chemistry/oligosaccharides.html

http://www.entrenasalud.es/glucogeno-y-deporte-un-gran-deposito-de-energia/

http://www.asturnatura.com/articulos/envoltura-celular/pared-celular.php

Tu opinión es importante

Estás invitado a enviar cualquier comentario o aportación que quieras realizar, gracias.